Apa itu NLP Pipeline? Panduan Lengkap Tentang Natural Language Processing (NLP) Pipeline

Saat ini, Natural Language Processing (NLP) merupakan salah satu bidang penting dalam teknologi AI yang memungkinkan mesin untuk memahami, menafsirkan, dan menghasilkan bahasa manusia.

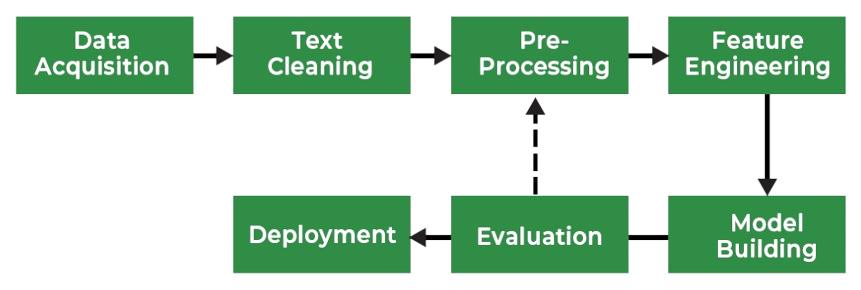

Pada inti dari NLP adalah NLP Pipeline, sebuah urutan terstruktur dari operasi yang menjadi tulang punggung dalam membangun aplikasi yang berfokus pada bahasa. Artikel ini akan membahas lebih dalam tentang tahapan-tahapan utama dalam NLP Pipeline serta keputusan-keputusan penting yang terlibat dalam merancang solusi yang efektif.

Apa itu NLP Pipeline?

NLP Pipeline adalah rangkaian tahapan yang saling terhubung secara sistematis mengubah data teks mentah menjadi output yang diinginkan dan siap untuk dianalisis. Dibandingkan dengan machine learning pipeline, di NLP kita perlu melakukan beberapa pemrosesan tambahan. Kenapa? Alasannya sederhana, karena mesin tidak memahami teks. Masalah terbesar kita di sini adalah bagaimana membuat teks dapat dipahami oleh mesin.

Nah, berikut adalah tahapan dalam NLP Pipeline:

1. Data Acquisition

2. Text Cleaning

3. Text Preprocessing

4. Feature Engineering

5. Modelling

6. Evaluation

7. Deployment

Perlu diingat :

Pipeline ini tidak bersifat universal atau linier namun dinamis dan dapat disesuaikan dengan kebutuhan Anda. Ada beberapa variasi tergantung pada jenis data dan tujuan yang ingin dicapai.

Mari kita bahas tahapannya lebih lanjut

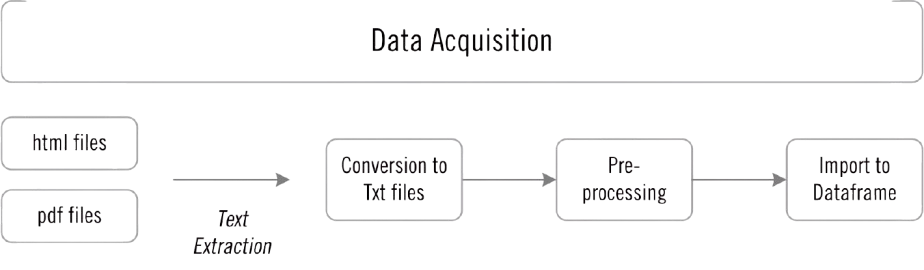

1. Data Acquisition

Seperti yang kita ketahui, untuk membangun model machine learning, kita memerlukan data yang relevan dengan kebutuhan kita. Terkadang, kita sudah memiliki datanya, tapi terkadang juga kita harus mencarinya. Data teks dapat ditemukan di situs web, email, media sosial, dalam bentuk PDF, dan masih banyak lagi. Tantangannya adalah apakah data tersebut tersedia dalam format yang dapat dibaca oleh mesin?

Nah, hal pertama yang perlu kita lakukan adalah memahami masalah atau tugas kita, kemudian mencari data yang relevan. Berikut beberapa cara mengumpulkan data jika tidak tersedia di database kita.

- Dataset Publik: Kita dapat mencari data yang tersedia secara publik sesuai dengan kebutuhan kita.

- Web Scraping: Web Scraping adalah teknik untuk mengambil data dari situs web. Kita bisa menggunakan Beautiful Soup untuk mengambil data teks dari halaman web.

- Image to Text: Kita juga bisa mengambil data dari file gambar dengan bantuan Optical Character Recognition (OCR). Ada library bernama Tesseract yang menggunakan OCR untuk mengubah gambar menjadi data teks.

- PDF to Teks: Terdapat beberapa Python packages yang dapat digunakan untuk meng-convert data PDF menjadi teks. Dengan menggunakan library PyPDF2, data PDF dapat diekstraksi menjadi file teks (.text).

- Data augmentation: Jika data yang kita peroleh tidak cukup untuk kebutuhan kita, kita bisa generate fake data dari data yang ada dengan mengganti Synonym, Back Translation, Bigram flipping, atau menambahkan beberapa noise pada data. Teknik ini dikenal sebagai Data augmentation.

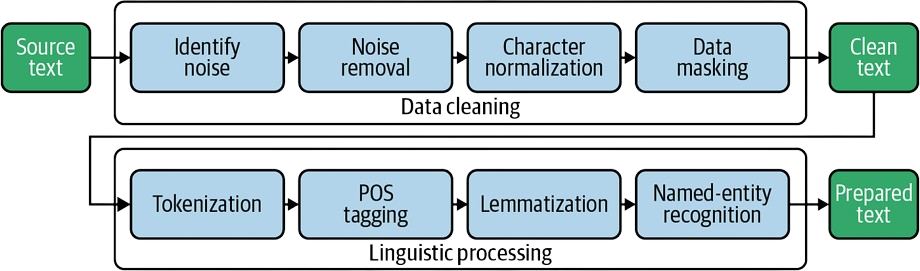

2. Text Cleaning

Terkadang data yang kita peroleh tidak terlalu bersih. Data tersebut bisa berisi tag HTML, kesalahan ejaan, atau karakter khusus. Berikut ini beberapa teknik untuk membersihkan data teks kita.

- Unicode Normalization: Jika data teks berisi simbol, emoji, karakter grafis, atau karakter khusus, kita dapat menghapus karakter-karakter tersebut atau mengkonversikannya ke teks yang dapat dibaca oleh mesin.

- Regex atau Regular Expression: Ini adalah tools yang digunakan untuk mencari string dengan pola tertentu. Misalnya, jika data kita berisi nomor telepon, alamat email, dan URL, kita dapat menemukan teks tersebut menggunakan regular expression. Setelah itu, kita dapat menyimpan atau menghapus pola teks tersebut sesuai kebutuhan.

- Spelling corrections: Ketika data kita diekstrak dari media sosial, kesalahan ejaan sangat sering terjadi. Untuk mengatasi masalah ini, kita dapat membuat korpus atau kamus kata-kata salah ketik yang paling sering terjadi dan mengganti kesalahan tersebut dengan kata yang benar.

3. Text Preprocessing

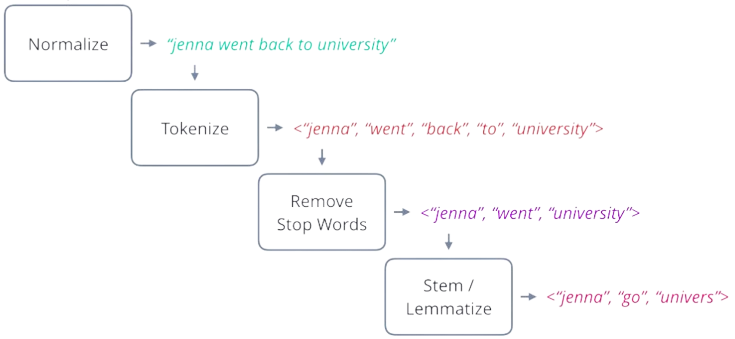

Preprocessing teks adalah tahap penting dalam NLP yang mencakup berbagai langkah untuk memperhalus data teks mentah agar siap untuk analisis dan pelatihan model. Tahapannya meliputi:

- Basic Cleaning: Menghapus elemen-elemen yang tidak relevan seperti tag HTML, emoji, dan memperbaiki kesalahan ejaan.

- Basic Preprocessing: Termasuk tokenisasi, penghapusan stop words, stemming/lemmatization, dan deteksi bahasa.

- Advanced Preprocessing: Melibatkan analisis linguistik yang lebih kompleks seperti POS tagging, parsing, dan resolusi coreference.

4. Feature Engineering

Feature engineering dalam NLP mengubah data teks mentah menjadi fitur numerik yang dapat dipahami dan dimanfaatkan oleh model machine learning. Beberapa teknik yang digunakan antara lain:

- Bag of Words (BoW): Mewakili teks sebagai kumpulan kata unik tanpa memperhatikan tata bahasa atau urutan kata.

- Term Frequency-Inverse Document Frequency (TF-IDF): Mengukur pentingnya kata dalam sebuah dokumen relatif terhadap korpusnya.

- One-Hot Encoding: Mewakili kata sebagai vektor biner di mana setiap kata memiliki indeks unik.

- Word Embeddings (Word2Vec, GloVe, FastText): proses konversi kata yang berupa karakter alphanumeric kedalam bentuk vector. Word embedding dapat menangkap hubungan semantik pada kata.

- Model N-Gram: Menangkap urutan kata yang berdekatan untuk menjaga beberapa informasi urutan.

- Dependency Parsing: Mewakili struktur gramatikal kalimat sebagai fitur.

5. Modelling

Ini adalah jantung dari pipeline di mana model diterapkan dan dievaluasi menggunakan berbagai pendekatan:

- Heuristic Approaches: Mengandalkan aturan yang telah ditetapkan berdasarkan pengetahuan ahli untuk membuat keputusan. Cocok untuk tugas teks sederhana seperti chatbots berbasis aturan.

- Machine Learning (ML) Model: Menggunakan model seperti SVM dan Random Forest untuk klasifikasi teks dan analisis sentimen.

- Deep Learning (DL) Model: Menggunakan jaringan neural seperti RNNs dan Transformers untuk tugas yang lebih kompleks seperti penerjemahan teks dan summarization.

6. Evaluation

Evaluasi dalam pipeline NLP mencakup penilaian intrinsik dan ekstrinsik untuk secara komprehensif mengukur performa model:

- Intrinsic Evaluation: Fokus pada aspek teknis dan kemampuan model dalam isolasi, seperti akurasi, precision, recall, dan F1-score.

Extrinsic Evaluation: Mengukur kinerja model dalam aplikasi dunia nyata atau konteks bisnis, seperti kepuasan pelanggan atau dampak pendapatan.

7. Deployment

Tahap ini menandai transisi model yang dikembangkan dari lingkungan pengembangan ke lingkungan produksi. Tahapan dalam deployment mencakup:

- Deployment: Meluncurkan model ke produksi, mengatur infrastruktur, dan memastikan skalabilitas serta keandalan.

- Monitoring: Memantau kinerja model secara berkelanjutan dan menerapkan sistem alert untuk mendeteksi anomali.

- Update: Memperbarui model untuk beradaptasi dengan pola data yang dinamis dan kebutuhan yang berkembang.

Tantangan dan Pertimbangan

- Data Drift: Perubahan pola data dapat mempengaruhi kinerja model. Update rutin diperlukan untuk mengatasi tantangan ini.

- Ethical and Legal Compliance: Model harus mematuhi standar etika dan regulasi hukum, terutama saat menangani data sensitif.

- Resource Management: Deployment yang efektif memerlukan manajemen sumber daya yang optimal untuk memastikan efisiensi biaya dan pemanfaatan komputasi.

Kesimpulan

NLP Pipeline adalah rangkaian langkah-langkah terstruktur yang digunakan dalam Natural Language Processing (NLP) untuk mengubah data teks mentah menjadi output yang berguna bagi berbagai aplikasi. Seiring dengan perkembangan teknologi, pipeline ini terus beradaptasi untuk mengintegrasikan teknik dan metodologi baru.

NLP Pipeline tidak bersifat universal atau linear, tapi lebih dinamis dan dapat disesuaikan dengan kebutuhan spesifik proyek.

Jika Anda berminat untuk mempelajari tentang teknologi NLP dan AI lebih mendalam, silakan mengikuti pelatihan terkait AI bersama SUHU disini :

- Webinar Natural Language Processing untuk Twitter Text Analysis

- Webinar Unlocking the Power of AI: GPT, Whisper and DALL-E

- Pelatihan Data Analysis with Python

- Pelatihan Deep Learning Python

- Pelatihan Data Science with Python

Silakan konsultasikan kebutuhanmu dengan kami, klik link https://bit.ly/kontaksuhu