Mengenal Hadoop dalam Big Data: Komponen, Cara Kerja, Ekosistem,dan Contoh Penggunaan Hadoop

Apa itu Hadoop?

Hadoop adalah software open source untuk menyimpan dan mengolah data besar secara terdistribusi dan scalable. Hadoop ditulis menggunakan bahasa Java dan dibangun berdasarkan algoritma MapReduce. Hadoop menyediakan penyimpanan besar dan kemampuan untuk menangani banyak tugas secara bersamaan.

Komponen Utama Hadoop

1. HDFS (Hadoop Distributed File System)

File system terdistribusi yang beroperasi di hardware standar maupun low-end. Sistem ini bekerja pada cluster komputer, menyimpan file besar (gigabytes hingga terabytes) di beberapa mesin. HDFS memecah file besar menjadi bagian-bagian kecil dan mendistribusikannya ke cluster untuk optimasi performa.

2. MapReduce

MapReduce adalah framework yang membantu program untuk melakukan komputasi secara paralel di seluruh cluster. Ada dua tahap MapReduce, antara lain:

- Map (Pemetaan)

Pada tahap ini, data dipecah menjadi potongan-potongan kecil. Masing-masing potongan kemudian diproses oleh fungsi map yang bisa melakukan filtering, sorting, atau operasi lainnya untuk menghasilkan pasangan key-value (kunci-nilai).

- Reduce (Pengurangan)

Setelah tahap map selesai, hasil berupa pasangan key-value tadi dikelompokkan berdasarkan key. Selanjutnya fungsi reduce akan memproses kelompok data yang memiliki key sama untuk menghasilkan output akhir.

3. YARN (Yet Another Resource Negotiator)

YARN (Yet Another Resource Negotiator) adalah sebuah framework manajemen sumber daya yang bertanggung jawab untuk mengatur dan memonitor cluster node dan resource usage. YARN mulai dikenal pada Hadoop 2.0 sebagai pengganti JobTracker dan TaskTracker pada Hadoop 1.0.

Dengan YARN, Hadoop dapat mendukung berbagai jenis aplikasi, seperti Spark, Storm, dan Hive, yang tidak hanya terbatas pada MapReduce.

Bagaimana cara kerja Hadoop

Hadoop bekerja dengan mendistribusikan data dan perhitungan ke seluruh kluster komputer, memungkinkan pemrosesan data secara paralel dan meningkatkan kinerja secara signifikan. Berikut ringkasan cara kerja Hadoop:

- Data disimpan di HDFS: Data dipecah menjadi blok-blok kecil dan disimpan di beberapa node dalam cluster.

- Aplikasi Hadoop dijalankan di YARN: YARN mengalokasikan sumber daya ke aplikasi Hadoop.

- MapReduce memproses data: MapReduce memecah tugas pemrosesan data menjadi dua tahap: Map dan Reduce.

- Hasil diproses disimpan di HDFS: Hasil pemrosesan data disimpan di HDFS.

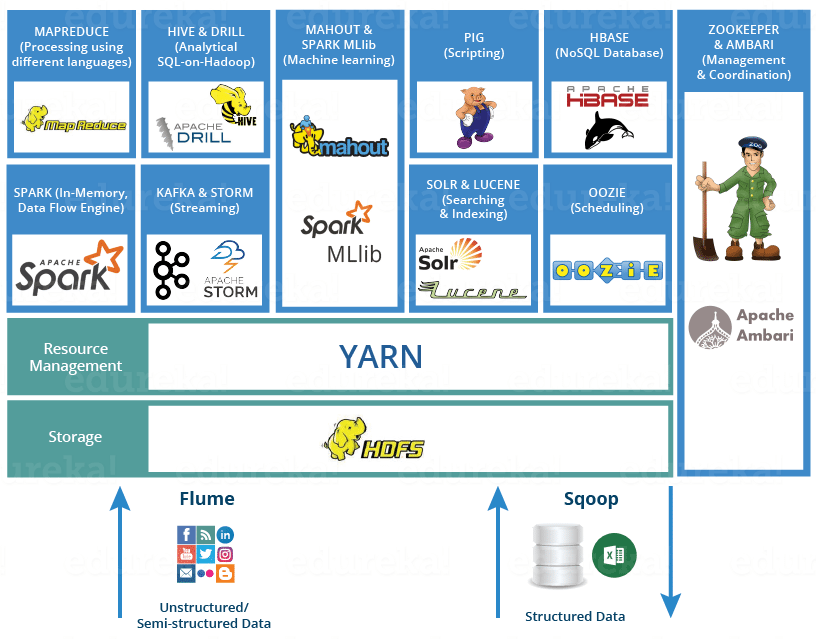

Ekosistem Hadoop

Hadoop memiliki ekosistem yang luas, yang terdiri dari berbagai tools dan framework yang saling melengkapi untuk mendukung analisis Big Data. Beberapa tools populer dalam ekosistem Hadoop antara lain:

- Hive: Data warehouse berbasis SQL yang memungkinkan pengguna untuk menganalisis data terstruktur dengan mudah.

- Pig: Platform pemrograman tingkat tinggi untuk analisis data yang terinspirasi dari bahasa pemrograman Pig Latin.

- Sqoop: Tool untuk mentransfer data antara database relasional dan HDFS.

- Spark: Framework pemrosesan data open-source yang menawarkan performa lebih cepat daripada MapReduce untuk aplikasi tertentu.

Contoh penggunaan Hadoop

Hadoop telah digunakan secara luas di berbagai industri untuk berbagai keperluan, seperti:

- Analisis web

Menganalisis data log web untuk memahami perilaku pengguna, pola traffic, dan performa website.

- Analisis media sosial

Mengumpulkan dan menganalisis data dari berbagai platform media sosial untuk memahami sentimen publik, tren, dan pola komunikasi.

- Deteksi penipuan

Menganalisis data transaksi keuangan untuk mendeteksi aktivitas penipuan.

- Rekomendasi produk

Menganalisis data pembelian dan perilaku pengguna untuk memberikan rekomendasi produk yang relevan.

- Penelitian ilmiah

Menganalisis data ilmiah yang kompleks untuk menemukan pola dan wawasan baru.

Kesimpulan

Hadoop telah menjadi salah satu platform Big Data yang paling populer dan banyak digunakan. Dengan skalabilitas tinggi, biaya rendah, fault tolerance, dan fleksibilitasnya, Hadoop menawarkan solusi yang kuat dan efisien untuk mengolah data dalam skala besar.

Ekosistem Hadoop yang kaya dengan berbagai tools dan framework memungkinkan pengguna untuk mengembangkan aplikasi Big Data yang sesuai dengan kebutuhan mereka. Hadoop diperkirakan akan terus berkembang dan menjadi platform penting dalam dunia Big Data.

Seperti itu penjelasan tentang Hadoop. Jika Anda berminat untuk mempelajari tentang Hadoop lebih mendalam, silakan mengikuti pelatihannya bersama SUHU disini :

Pelatihan Big Data with Hadoop

Silakan konsultasikan kebutuhanmu dengan kami, klik link https://bit.ly/kontaksuhu